如何防止AI员工产生算法歧视性判断

如何防止AI员工产生算法歧视性判断

随着人工智能的不断发展,AI已经在各个领域得到广泛应用,甚至成为了企业的“员工”。然而,如何保证AI员工的决策不受任何形式的歧视性影响,尤其是算法歧视,成为了一个迫切需要解决的问题。本文将从数据来源、算法设计、以及伦理与教育等角度,深入探讨如何防止AI员工产生算法歧视性判断。

一、优质数据源的重要性

算法歧视很大程度上来源于不均衡或者偏见的数据集。为了预防AI员工的决策被歧视性偏见影响,我们需要首先从源头入手——即确保训练数据的高质量和多元性。选择多元化且能真实反映人口和社会多元特征的数据源至关重要,它能有效地降低由于训练数据的偏颇导致歧视的可能。此外,还应该利用交叉验证等手段进行数据的全面处理和分析。

二、算法设计的公正性

在算法设计阶段,我们需要确保算法的公正性。这包括但不限于使用无偏见的机器学习模型,以及在模型训练过程中进行公正性测试和监控。另外,利用公正性增强技术(如去偏技术)也是重要的步骤。这能有效地降低由于算法模型本身的偏见导致歧视的风险。

三、避免歧视的监督与自反馈机制

建立一个专门的算法监管与反馈系统至关重要。系统应当能够在机器学习和处理数据时对可能出现歧视的行为进行监督和干预,以及时的对发现的任何潜在的歧视性问题进行调整。另外,设立匿名检查系统能进一步提升这个机制的效果。它可以使更多未涉事其事的第三人,如其他专家或公众,参与到监督过程中来。

四、伦理与教育的双重保障

除了技术层面的措施外,我们还应该重视伦理和教育的双重保障。企业应制定明确的AI伦理规范和操作指南,确保AI员工的决策始终符合道德和社会期望。同时,应该为相关工作人员提供全面的教育和培训,提升他们的数据和算法意识,以及对可能存在的歧视性偏见的认识和处理能力。

五、社会和政府的责任

此外,防止AI员工产生算法歧视性判断并非只是企业或个人的责任。社会和政府也应当承担起相应的责任。政府应制定并执行相关的法律法规,以保护公民免受因AI决策产生的歧视性影响。同时,社会应积极推动公众对AI决策过程的理解和信任,提高公众的知情权和参与度。

六、持续的监测与改进

最后,防止AI员工产生算法歧视性判断是一个持续的过程。我们需要定期对AI系统的决策进行监测和评估,检查是否产生了新的偏见或者问题。在发现问题时应及时修正算法并进行数据校正。这样才能持续改进和提高我们的系统。

总之,为了防止AI员工产生算法歧视性判断,我们应当从源头着手、进行科学公正的算法设计、建立有效的监督与反馈机制、重视伦理与教育、明确社会和政府的责任并持续进行监测与改进。通过这些措施的协同作用,我们可以更有效地保证AI员工的决策公正、公平和可靠。

查看未读消息

查看未读消息 查看最新消息

查看最新消息

分享

分享

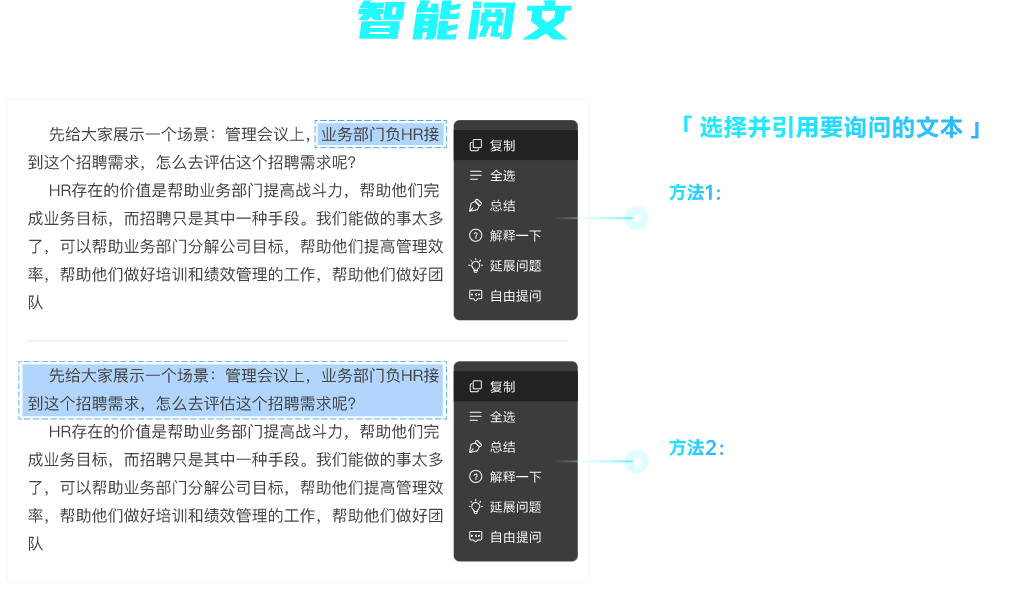

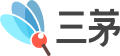

复制

复制 全选

全选 总结

总结 解释一下

解释一下 延展问题

延展问题 自由提问

自由提问

复制

复制 分享

分享